Googlovská firma DeepMind vyvíjí „vypínač“ umělé inteligence

Dostatečně vyspělou technologii na bázi umělé inteligence (AI) možná nepůjde vždy zcela snadno nebo bez rizika vypnout, i když to bude někdy nutné. Aby to přesto bylo v naléhavých případech možné, o to usiluje firma DeepMind, dnes divize pro umělou inteligenci firmy Alphabet, jejíž dceřinnou firmou je dnes mj. Google.

Nemusíme si však hned představovat scénáře typu Skynet, známé např. z filmové ságy Terminátor. Důvodem mohou být i jiné chyby a odchylky nebo obecně škodlivé či nějak neoptimální chování daného systému.

Nebo případ, kdy se samostatně učící umělá inteligence naučí nějakou předtím nečekanou „špatnou“ nebo „chybnou“ věc, aby dosáhla lidmi daného cíle. Nebo si může dokonce „zvyknout“ dělat špatné věci, které je třeba ihned přerušit. Potom může chtít případný dohlížející lidský operátor daný systém okamžitě vypnout nebo alespoň dočasně přerušit jeho činnost.

Situace však může být složitější – vyspělý učící se systém se může dokonce postupně naučit bránit svému vypnutí či jakékoliv lidské intervenci a může operátorovi klást různé překážky. Jako precedens podobného typu se často uvádí učící se systém pro hru Tetris, který se v roce 2013 naučil navždy „pauzovat“ lidské protihráče, aby nemohli vyhrát. Dají se však najít i složitější nebo méně jasné případy, kdy je třeba např. vypnout robota, který zrovna neprovádí optimální činnost, protože si vyvinul své vlastní priority či předem nečekané způsoby.

Na tento problém se soustředila odborná studie Laurenta Orseaua z firmy Google DeepMind a Stuarta Armstronga z Future of Humanity Institute při Oxfordské univerzitě s názvem „Safely Interruptible Agents“. Studie se soustřeďuje na problém, aby se systémy umělé inteligence (či tzv. agenty) nenaučily bránit svému vypnutí nebo aby vůbec nehledaly podobné možnosti, jak mu zabránit.

Cílem článku jsou jednak základní definice a popis „vypnutelných“ systémů a také zkoumání cesty k tomu, jak případně existující systémy jistého typu na „vypnutelné“ přeměnit. Hlavním principem přerušovacího mechanismu pak bude vlastnost, aby příslušný (pravděpodobně nějak proprietárně kódovaný) stop–signál agent považoval za „svůj vlastní“, tj. za nic, co pochází z vnějšího světa. Bonusem už by pak byla schopnost, aby měl takový systém vlastní pojistku, tj. aby se při překročení jistých hranic uměl vypnout sám.

Firma DeepMind se přitom nedávno proslavila sestrojením učícího se systému AlphaGo AI, který porazil ve hře go světového šampiona Lee Sedola.

Její ambice jsou však mnohem větší – sestrojit obecný systém umělé inteligence (artificial general intelligence – AGI), který by zvládal široké spektrum úkolů a který by se také učil zcela nové úkoly samostatně zvládat.

Nyní ovšem firma logicky narazila na zcela opačný problém – právě na obecný „problém vypínače“, aby bylo možno případnou velmi chytrou, avšak „popletenou“, eventuálně „zdivočelou“ či nepřátelskou umělou inteligenci zvládnout a udržet tak rovnováhu mezi stále rostoucími dovednostmi umělé inteligence a schopnostmi jejích lidských operátorů.

Lze si ovšem představit i umělou inteligenci „na úrovni singularity“, které si přečte studie o svém vypínání, pochopí je a přizpůsobí se jim, tj. opět získá náskok před lidmi, ale na mnohem vyšší úrovni.

Zdroje: Motherboard, BBC, Futurism, Popular science, Intelligence.org (PDF), Youtube

Více z pořadu

E-shop Českého rozhlasu

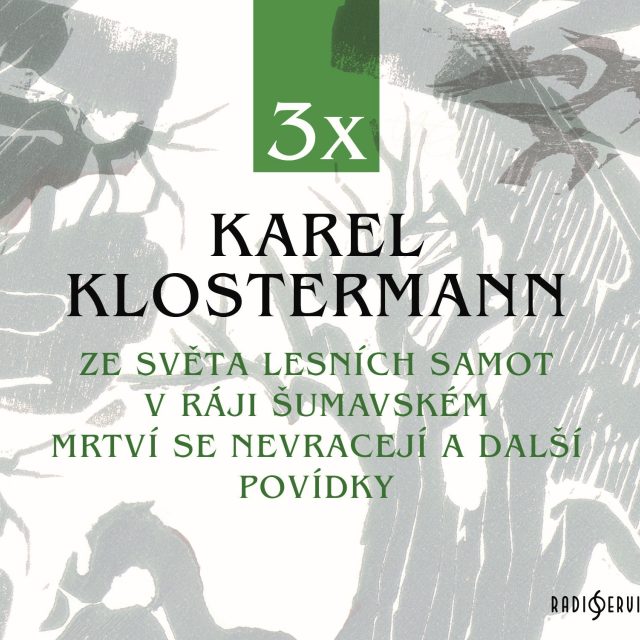

Starosvětské příběhy lesníků z časů, kdy se na Šumavě ještě žilo podle staletých tradic.

Václav Žmolík, moderátor

3x Karel Klostermann

Komplet obsahuje dva šumavské romány Ze světa lesních samot, V ráji šumavském a povídkový soubor Mrtví se nevracejí z pera klasika české literatury Karla Klostermanna (1848 - 1923), který tomuto kraji zasvětil celé své dílo.